发布日期:2025-06-14 07:23 点击次数:187

智东西

智东西

端侧模子的产业坐标系正在被重塑!

一方面,昨日凌晨,AI浓度大大镌汰的苹果WWDC中,苹果智能(Apple Intelligence)正加快融入到系统各个功能中,同期苹果晓示向所有这个词App盛开权限允许开采者平直造访苹果智能中枢的建树端大说话模子,建议“Foundation Models框架”也激发了不小的揣度;另一方面,上周面壁智能发新一代面壁小钢炮MiniCPM4.0端侧模子,0.5B模子性能超Qwen-3-0.6B、以及参数领域1B的Llama 3.2、Gemma3。

这些不错诠释,端侧智能从可用到能用、好用,从技巧认识到东说念主东说念主可及的距离正在被速即拉近。比拟于云霄模子,端侧智能以隐秘安全、反映高效、本钱可控、场景适配的自然上风,与咱们生计中的硬件建树细腻连接。

端侧AI变得无处不在的配景下,当苹果以生态级框架镌汰端侧AI开采门槛时,面壁智能MiniCPM4.0的技巧突破更具底层蜕变价值,进一步击穿了端侧智能的性能天花板。

MiniCPM4.0的技巧突破具备多么价值?其在AI诳骗爆发确当下有何要害性?咱们将从端侧模子发展的底层逻辑起程,找到这些问题的谜底。

技巧诠释:https://arxiv.org/pdf/2506.07900Github模子下载率领:https://github.com/openbmb/minicpmHuggingface模子下载率领:https://huggingface.co/collections/openbmb/minicpm-4-6841ab29d180257e940baa9bModel Scope模子下载率领:https://www.modelscope.cn/collections/MiniCPM-4-ec015560e8c84d一、端侧AI发展已成势必趋势,技巧创新堕入“增量窘境”端侧模子部署已成为行业公认的技巧趋势,但是现时翻新性的技巧创新相对匮乏,且在施行诳骗中濒临推理速率瓶颈、功耗扫尾难题以及高下文领会智商不及等多重挑战,这会平直影响结尾用户的交互体验。

苹果看成智妙手机的要害玩家,其这次在WWDC上发布的Foundation Models框架,背后微辞折射出端侧AI生态行将爆发的趋势。

Foundation Models框架的作用是闪开采者将我方的App唐突调用苹果智能,竣事离线运行、隐秘保护且无推理本钱,更直不雅来说即是开采者无需支付调用云霄大模子API产生的token用度,用户亦无需为此支付畸形本钱。

不错看出,这么的端侧AI生态本色上不错突破传统云霄AI的“本钱-隐秘-延伸”三角制约,让技巧价值在开采者、用户等各门径竣事高效传导。

与此同期,端侧AI的爆发亦体现到了建树躲避的庸俗性之上,从智妙手机、条记本电脑到智能汽车,乃至机器东说念主品类,端侧模子部署正全面浸透至种种智能结尾场景。

但是,与端侧AI焕发发展的近况造成明显反差的是,在现存技巧旅途下探寻端侧基座模子跃升的突破口仍费力重重,访佛DeepSeek在基础模子领域激发的气候级突破事件更是凤毛麟角。

如今参数领域小到足以在端侧部署的模子已不在少数,这些模子虽具备基础的领会与生成智商,但在性能突破方面仍濒临显赫瓶颈。

这与端侧建树本人的诸多特质研究。

端侧建树的一大特征即是电板容量和散热遐想等硬件架构受限,濒临严格的能耗不停,需动态进行功耗照顾与分派,且容错率较云霄更低。

再加上为了适配内存,端侧模子和会过剪枝、蒸馏等技巧压缩模子领域,此举一定进程上会丢失长序列建模智商,导致多路对话时丢失历史信息。

在推理速率方面,诚然端侧建树距离用户数据更近,但其芯蓦地常会受限于制程工艺和面积,使得典型端侧算力较云霄GPU相对较低。

尽管濒临这些现实挑战,但端侧模子的突破,正是当下行业将要点聚焦于AI诳骗之际,使得诳骗爆发的前提条目之一。正如面壁智能CEO李大海所说,端侧基模是AI时期端侧操作系统级基础设施,其智商平直决定表层诳骗的天花板,就像Windows之于PC诳骗、Android之于转移诳骗,莫得浩大的基模撑合手,表层诳骗就难有突破。

二、首个原生寥落模子,攻克端侧长文本难题那么,端侧模子破局的要道突破口究竟在哪?咱们不错从上周面壁智能新发的端侧模子MiniCPM-4不错窥见这个问题的谜底之一。

这次面壁智能发布的MiniCPM4.0共有8B和0.5B两种参数领域,这两个“以小搏大”的模子要道特质不错用庸俗躲避中端场景、长文本登陆端侧、低支出并排同领域模子详细。

具体来看,寥落凝视力模子MiniCPM 4.0-8B,在MMLU、CEval、MATH500、HumanEval等基准测试中,以22%的考研支出,性能并排Qwen-3-8B,突出Gemma-3-12B;MiniCPM 4.0-0.5B则以2.7%的考研支出,相较Qwen-3-0.6B、1B参数领域的Llama 3.2竣事了性能翻倍,且通过原生QAT(量化感知考研)技巧竣事INT4低精度量化,竣事高达600 Tokens/秒的推理速率。

在128K长文本场景下,MiniCPM 4.0-8B相较于Qwen3-8B仅需1/4缓存存储空间,量化版竣事90%的模子瘦身。在显存受限极限场景下,8B模子竣事长文本推理速率5倍老例加快以及最高220倍加快。

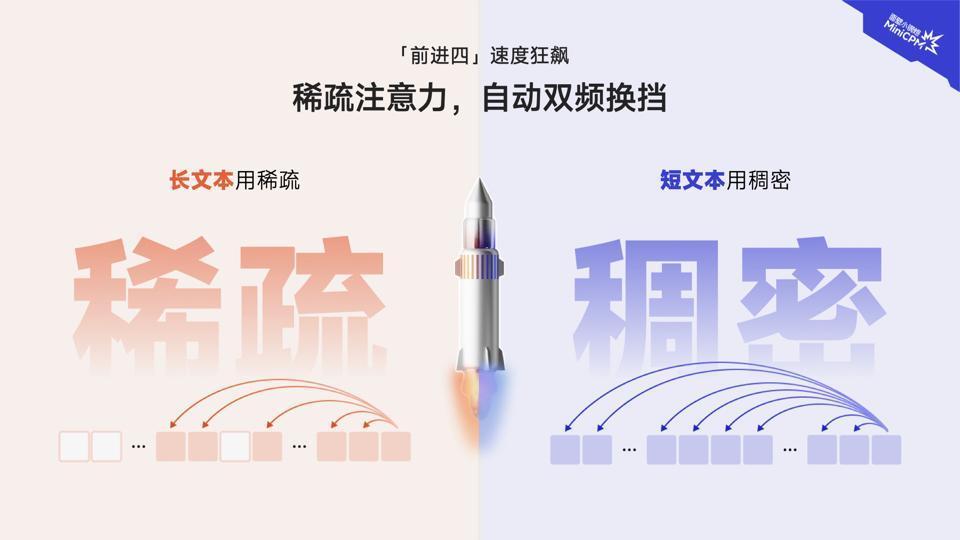

同期为了保证运行通达,其在凝视力机制层面竣事高效双频动态换挡,长文本自动激活寥落打算样式,漫笔本智能切换富贵打算样式。

为了进一步升迁端侧长文本的诳骗范围,面壁智能在8B模子之上微调出两个特定智商模子,分别不错用作念MCP Client和纯端侧性能并排Deep Research的研究诠释神器MiniCPM4-Survey。

值得凝视的是,与云霄模子处理长文本场景不同,端侧模子要竣事同等性能濒临更高技巧挑战,此前堆参数、堆算力等阶梯在端侧很难走通,因此技巧创新成为端侧突破瓶颈的中枢驱能源。

面壁智能在架构、推理层面的系列创新就考证了这条路。

从MiniCPM4.0的前缀就不错看出长文本在端侧落地的杀手锏——首个开源原生凝视力寥落模子。

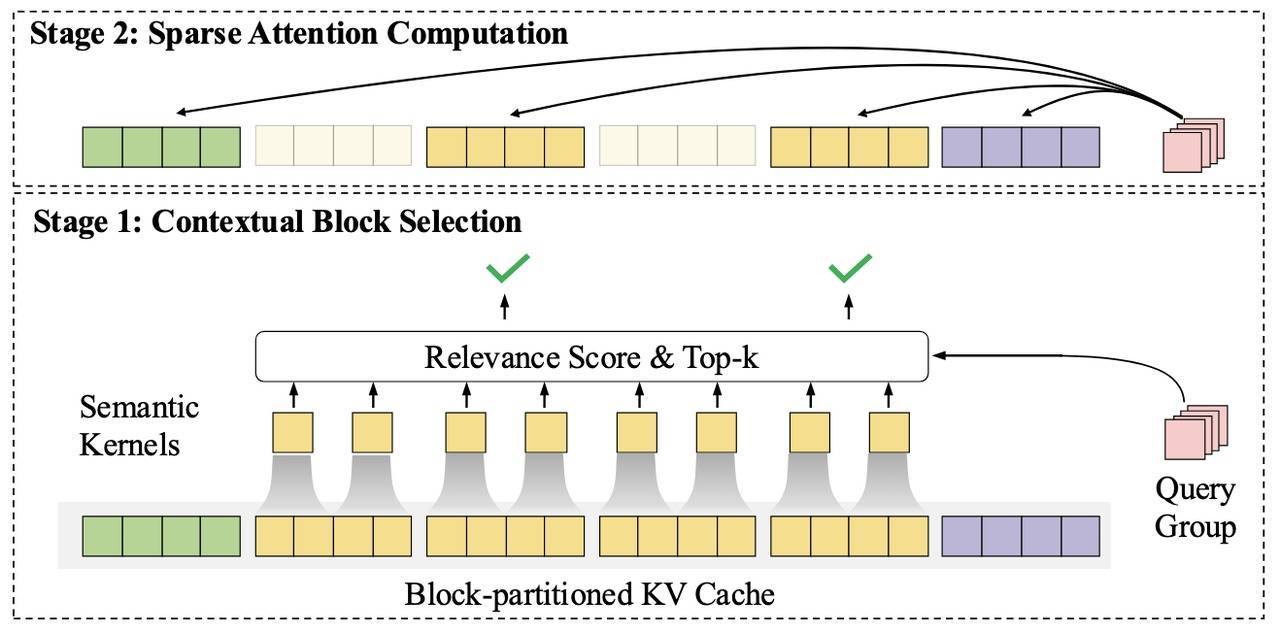

模子领受的新一代InfLLMv2寥落凝视力架构,一改传统Transformer模子的联系性打算表情,而是竣事分块分区域高效“抽查”,行将文本永别为多个孤苦区域,然后通过智能化遴荐机制对最有联系性的要点区域进行凝视力打算“抽查”,不错幸免逐字重叠打算,适配于转移端或轻量化部署。

▲InfLLMv2寥落凝视力架构

基于更精确的高下文块遴荐算法、更细粒度的查询词元分组、更高效的算子竣事,InfLLMv2将寥落度从行业渊博的40%-50%降至5%,凝视力层仅需1/10的打算量即可完成长文本打算。

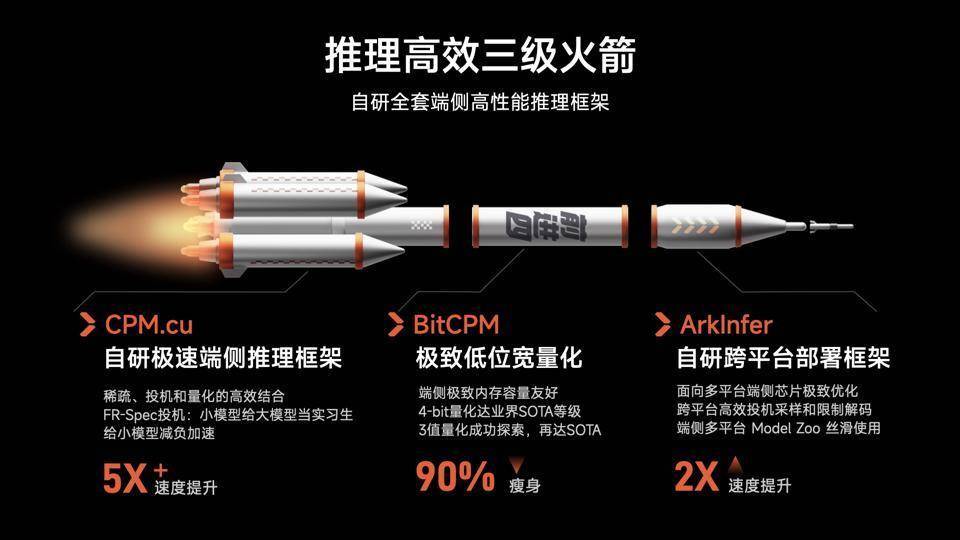

另一个杀手锏针对的是推理加快——自研全套端侧高性能推理框架。

这相似是面壁智能系列自研着力的体现:CPM.cu自研推理框架、P-GPTQ前缀敏锐的模子考研后量化、BitCPM极致低位宽量化、ArkInfer自研跨平台部署框架等,欲补皆端侧推理加快的每一块短板。

大模子部署时要辩论打算与内存滥用难题,同期端侧芯片碎屑化会导致多平台适配与部署工程痛点。

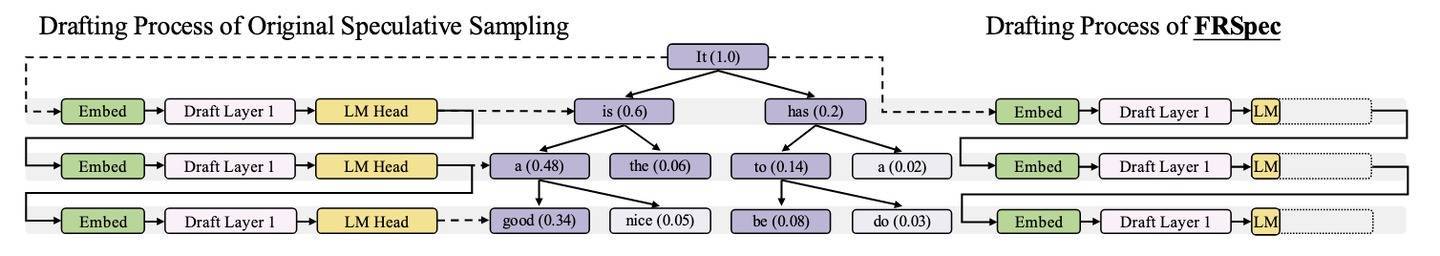

在此基础上,面壁智能专为端侧英伟达芯片优化了自研轻量化推理框架CPM.cu,能集成静态内存照顾、算子交融、高效投契采样、前缀敏锐的量化算法等多种智商,高效组合寥落、投契、量化的同期,竣事5倍速率升迁;同期领受P-GPTQ和BitCPM三值量化规律,以进一步优化资源滥用。

▲轻量化推理框架CPM.cu

对于芯片碎屑化带来的复杂模子适配和部署过程,面壁智能建议的ArkInfer引入跨平台兼容的架构遐想、可复用且高效的估量采样与不停解码有经营、可膨胀的模子库前端等贬责有经营。

总的来看,从投契采样、模子压缩量化到端侧部署框架,无一不是面壁智能在算力、内存局限性都更高的端侧发力的要道,让端侧长文本智商竣事从0到1的进阶。因此,李大海将MiniCPM4.0的发布界说为“其在模子架构遐想、数据治理、学习规律、软硬协同等方面突破的一次麇集着力展示,是一次创新的告捷”。

三、端侧诳骗爆发的基础设施翻新开启,重构端侧诳骗的场景范围从宏不雅维度来看,端侧基座模子性能的升级对于产业发展有两方面要害真谛。

最直不雅的影响即是加快端侧诳骗的爆发。

基础模子是一切表层诳骗的发动机,但如今端侧基座模子并不够好。李大海将现时端侧的基座模子类比为19世纪的蒸汽机,其虽已在一定进程上产生了改变寰宇的基因,但着力、可靠性和普适性远未达标,距离成为鼓吹AI普及的“万用发动机”还有一段距离。

因此考研更智能、更好用的端侧模子在当下显得更为要紧。

此外,端侧模子需要更好领会长文本的举座结构和语义才调使其精确捕捉用户需求。端侧建树之上有多半触及聊天记载、位置、浏览等信息的用户个东说念主信息,这些信息不仅是模子阐扬浩大智商的要道,同期也承载了用户的私东说念主信息无法上传到云霄,因此长文本对于端侧AI诳骗场景的膨胀至关要害。

MiniCPM4.0的长文本智商就进一步膨胀了端侧模子部署、诳骗开采的瞎想空间。

从更永久的视角来看,新行业发展机遇的破土而出,向来与技巧创新的迭代演进同步,行业发展共鸣与底层创新技巧驱动相反相成。

面壁智能在端侧模子领域的布局即是很好的诠释,其专注于通过科学化、本钱可控的底层创新。区别于业界渊博领受的“自便出古迹”阶梯,其从数据、考研、学习、推理等层层过程,均竣事研发进入产出比的最大化。

上文提到的寥落凝视力研究InfLLM,正是2024年面壁智能与清华大学NLP实验室聚合发布的研究着力,并在当下为产业创新提供了能源,这一念念路就体现到了DeepSeek领受的长文本处理架构NSA(Native Sparse Attention)中,二者在寥落凝视力机制的技巧本源上世代相承。

到如今,在此基础上头壁智能推出了InfLLM新版块,补皆在漫笔本推理的短板。

这一从基础研究突破到工程化阅兵,再到不同场景智商膨胀的技巧良性轮回闭环,正是当下大模子产业良性发展的灵活注脚。

更为底层的即是当下大模子开源生态的爆发,李大海清晰,面壁智能坚合手开源,小钢炮MiniCPM系列全平台下载量已累计破1000万。

而这次陪同MiniCPM4.0的发布,其开源属性进一步透明,从参数、高质地预考研数据、寥落加快算子和框架都竣事了开源。

在技巧创新与诳骗场景膨胀的双重解围下,端侧AI的爆发为期不远。

回溯近两年来大模子产业发展,对于大模子Scaling Law发展际遇瓶颈、互联网低本钱公开可用数据行将用尽的争论频发,均使得业界启动再行念念考奈何竣事AGI;本岁首DeepSeek V3/R1系列高效模子环球出圈,通过技巧创新鼓吹模子考研和推理本钱合手续下落正逐渐成为业界共鸣,这些都是端侧AI爆发的种子。

清华大学长聘副教会、面壁智能首席科学家刘知远合计,智能翻新的到来不成能依赖模子越大智商越强的领域法律解释(Scaling Law),而要通过技巧创新升迁模子智商密度,从而用更低本钱构建和使用更强智能,竣事AI的高质地、可合手续发展。

因此,咱们也不错感受到端侧基础模子在当下AI发展中的要害性。他也勇猛发出预计:“惟有是这个寰宇上仍是竣事的大模子智商,跟着时分的演进和技巧的跳跃,最终都不错在主流结尾如PC、手机、汽车或机器东说念主上通达运行。”

面壁智能正在野着这一经营冲刺。

结语:端侧智能迈入新时期面壁智能一直起劲于于将大模子技巧推向端侧,竣事高效的端侧智能,新一代面壁小钢炮模子MiniCPM4.0的发布更具里程碑真谛,其象征着端侧智能进入全新时期,

基于此,将来咱们有望看到更多的智能建树具备浩大的AI智商,伴跟着从消费级结尾到行业贬责有经营,AI概况不错通过端侧化,信得过竣事从实验室到千门万户、千行百业的普惠落地赌钱赚钱app,开启东说念主机智能协同的全新时期。